站长之家(ChinaZ.com)3月31日 消息:AI芯片初创公司Cerebras宣布进军大型语言模型领域,推出了七种新的开源语言模型。称为Cerebras-GPT 的模型系列的大小范围从1.11亿个参数到130亿个参数。

这家初创公司表示,这些模型使用 DeepMind 的Chinchilla公式进行训练,旨在让任何人都能以更低的成本使用它们,其消耗的能量实迄今为止公开可用的模型中最少的。

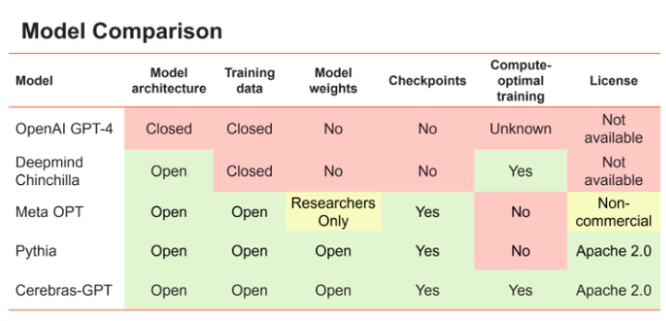

Cerebras 决定构建并提供这些开源模型它认为访问应该更加开放。Cerebras ML 研究科学家 Nolan Dey 在博客文章中写道:“最新的大型语言模型OpenAI 的GPT-4发布时没有关于其模型架构、训练数据、训练硬件或超参数的信息。该公司越来越多地使用封闭数据集构建大型模型,并仅通过 API 访问提供模型输出。要让 LLM 成为一种开放和可访问的技术,我们认为重要的是能够访问最先进的模型,这些模型对于研究和商业应用都是开放的、可复制的和免版税的。”

Cerebras模型的数据集尚未公开,目前可以通过HuggingFace访问模型本身。

在全球最大芯片上训练模型

Cerebras 以其WSE-2芯片而闻名,它是世界上最大的芯片之一,类似于一个8x8英寸的平板,每个平板包含2.6万亿个晶体管和85万个“人工智能优化”内核。

Cerebras 的CS-2系统包含大量 WSE-2AI 芯片。这家初创公司采用了其中的16个系统来为其 AI 超级计算机 Andromeda 提供动力。Andromeda于去年11月发布,旨在大大减少训练大型语言模型所需的时间。

这家初创公司甚至声称超级计算机可以处理具有巨大序列长度的大型语言模型,这是传统 GPU 根本无法做到的。在去年底接受AI Business采访时,Cerebras 首席执行官 Andrew Feldman 表示 Andromeda 已经帮助进行了 COVID-19研究。

这家初创公司已将注意力转向大型语言模型,以此来展示其技术的能力。

Cerebras-GPT 模型是在 Andromeda 上训练的,Cerebras 表示它能够“快速完成训练,无需GPU集群上所需的传统分布式系统工程和模型并行调优。” 用于训练 Cerebras-GPT 模型的集群也已通过Cerebras AI Model Studio在云端提供。

促进大语言模型大众化

主要的人工智能实验室已经做了很多开发语言模型的工作,但却隐瞒了有关底层系统如何工作的信息。例如,OpenAI在本月早些时候发布GPT-4引起了愤怒,只是透露了很少的技术规格,却没有提及所使用的确切数据或尺寸细节。

很多人,比如斯坦福大学的 AI 研究人员,认为由于 OpenAI 等公司已经关闭了他们的模型,这使得对这些技术的潜在影响进行研究变得更加困难。

Cerebras 设计了新模型以提供更广泛的访问,并表示希望这些模型将“作为有效培训的秘诀,并作为进一步社区研究的参考。”

站长之家注:

Cerebras-GPT 官方博客网址:https://www.cerebras.net/blog/cerebras-gpt-a-family-of-open-compute-efficient-large-language-models/

Cerebras-GPT模型HuggingFace网址:https://huggingface.co/cerebras

(举报)