8月28日,腾讯混元宣布开源端到端视频音效生成模型HunyuanVideo-Foley,这一模型能够通过输入视频和文字为视频匹配电影级音效,为视频创作带来了新的突破。用户只需输入相应的文本描述,HunyuanVideo-Foley就能生成与画面精准匹配的音频,从而打破AI生成视频只能“看”不能“听”的局限,让无声AI视频成为历史。

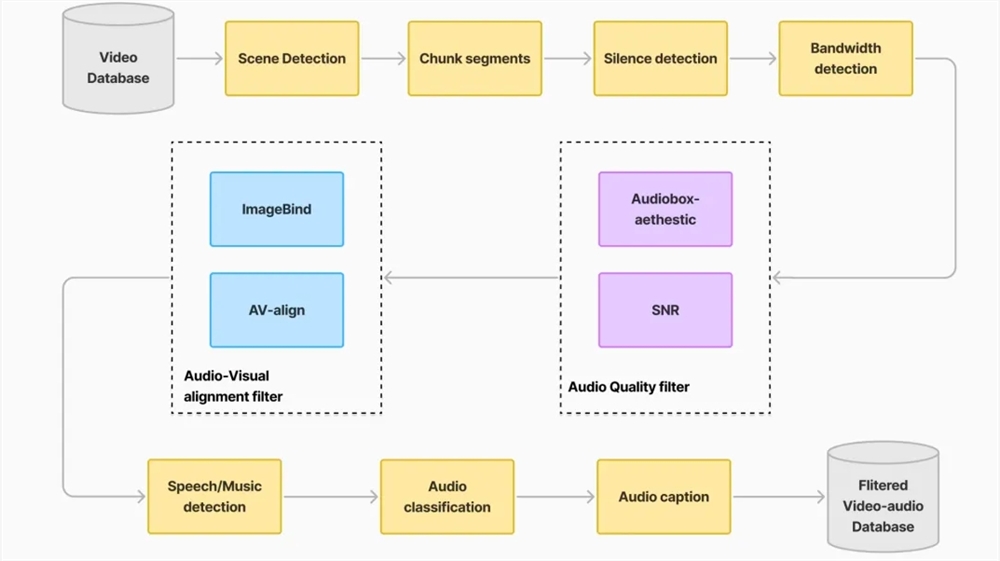

HunyuanVideo-Foley的出现解决了现有音频生成技术面临的三大痛点。首先,它通过构建大规模高质量TV2A(文本-视频-音频)数据集,提升了模型的泛化能力,使其能够适配人物、动物、自然景观、卡通动画等各类视频,并生成与画面精准匹配的音频。其次,该模型采用创新的双流多模态扩散变换器(MMDiT)架构,能够平衡文本和视频语义,生成层次丰富的复合音效,避免了因过度依赖文本语义而导致的音频与场景脱节问题。最后,HunyuanVideo-Foley通过引入表征对齐(REPA)损失函数,提升了音频生成的质量和稳定性,保证了专业级的音频保真度。

在多个权威评测基准上,HunyuanVideo-Foley的性能表现全面领先,其音频质量指标PQ从6.17提升至6.59,视觉语义对齐指标IB从0.27提升至0.35,时序对齐指标DeSync从0.80优化至0.74,均达到了新的SOTA水平。在主观评测中,该模型在音频质量、语义对齐和时间对齐三个维度的平均意见得分均超过4.1分(满分5分),展现了接近专业水准的音频生成效果。

HunyuanVideo-Foley的开源为行业提供了可复用的技术范式,将加速多模态AI在内容创作领域的落地。短视频创作者可以一键生成场景化音效,电影团队能够快速完成环境音设计,游戏开发者可以高效构建沉浸式听觉体验。

目前,用户可以在Github、HuggingFace下载模型,也可以在混元官网直接体验。

体验入口:https://hunyuan.tencent.com/video/zh?tabIndex=0

项目官网:https://szczesnys.github.io/hunyuanvideo-foley/

代码:https://github.com/Tencent-Hunyuan/HunyuanVideo-Foley

技术报告:https://arxiv.org/abs/2508.16930

Hugging Face:https://huggingface.co/tencent/HunyuanVideo-Foley