Liquid AI 正式推出 LFM2-VL,这是一款全新的视觉语言基础模型系列,专为低延迟和设备适应性部署而优化。此次发布的 LFM2-VL 模型包括两个高效的变体:LFM2-VL-450M 和 LFM2-VL-1.6B,这标志着多模态 AI 在智能手机、笔记本电脑、可穿戴设备和嵌入式系统中的应用取得了重要进展,而不牺牲速度和准确性。

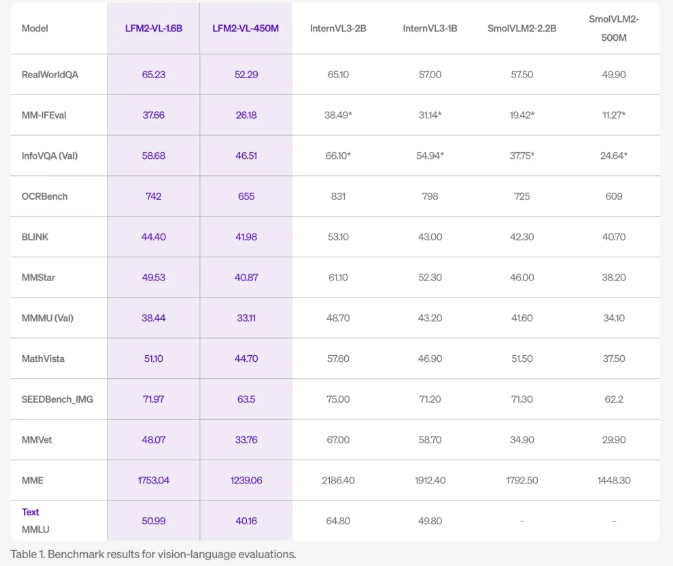

LFM2-VL 模型经过精心设计,相比现有的视觉语言模型,其 GPU 推理速度提高了两倍,同时在图像描述、视觉问答和多模态推理等任务上保持了竞争力的基准表现。450M 参数的版本专为资源受限的环境而设计,而1.6B 参数的版本则在保持轻量级的同时,提供更强大的能力,适合单 GPU 或高端移动设备使用。

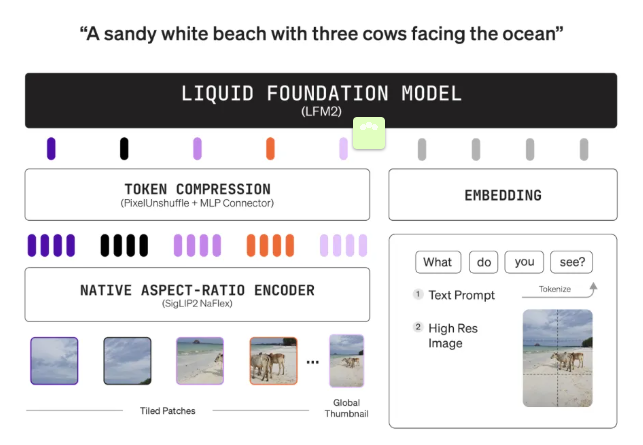

在技术创新方面,LFM2-VL 采用模块化架构,结合了语言模型主干(LFM2-1.2B 或 LFM2-350M)、SigLIP2NaFlex 视觉编码器(400M 或86M 参数)和多模态投影器,使用 “像素解混” 技术动态减少图像标记数量,以实现更快的处理速度。此外,模型能够以原始分辨率处理图像,最高可达512×512像素,避免了因放大而造成的失真。较大的图像会被分割为不重叠的512×512补丁,确保细节和长宽比的保留。1.6B 版本还会编码全图的缩小缩略图,以便提供全球上下文理解。

LFM2-VL 模型的灵活推理能力使用户能够在推理时调整速度和质量的平衡,适应设备能力和应用需求。模型经过预训练、联合中训练以融合视觉和语言能力,最终在大约1000亿个多模态标记上进行了微调,确保了其在图像理解方面的出色表现。

在公共基准测试中,LFM2-VL 的表现与 InternVL3和 SmolVLM2等大型模型相媲美,但内存占用更小、处理速度更快,非常适合边缘和移动应用。两种模型均为开放权重,并可在 Hugging Face 上下载,适用于研究和商业使用。对于大型企业,则需联系 Liquid AI 以获取商业许可证。这些模型与 Hugging Face Transformers 无缝集成,并支持量化,以进一步提升在边缘硬件上的效率。

LFM2-VL 旨在帮助开发者和企业快速、准确且高效地在设备上部署多模态 AI,减少对云的依赖,推动机器人、物联网、智能摄像头和移动助手等新应用的出现。

huggingface:https://huggingface.co/collections/LiquidAI/lfm2-vl-68963bbc84a610f7638d5ffa

划重点:

🌟 LFM2-VL 模型提供超高效的 GPU 推理速度,比现有模型快两倍,适合各种设备使用。

🖼️ 支持原始分辨率处理图像,并且能够处理大图像,确保细节不失真。

🚀 两种模型均为开放权重,可在 Hugging Face 上下载,适合研究和商业应用。