站长之家(ChinaZ.com)8月15日 消息:最近,Meta AI 提出了一种新的语言模型叫做 "牧羊人"(Shepherd),用于评估其他模型生成的文本,并给出改进建议。这个模型使用了约70亿个参数,并通过社区反馈和人工标注的数据集来进行训练。

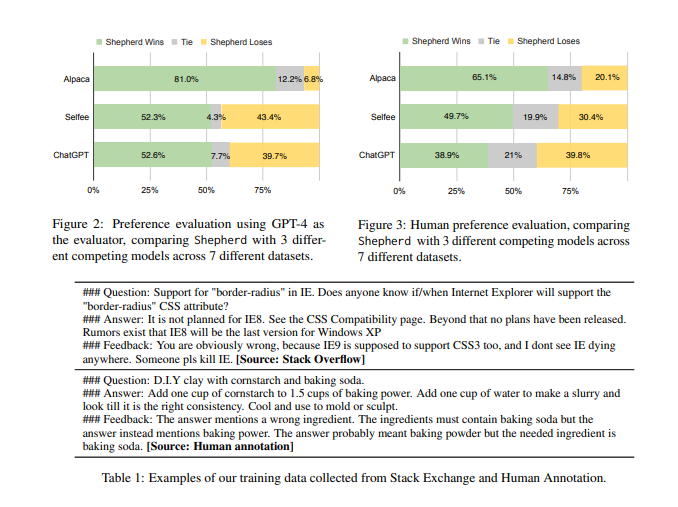

"牧羊人" 模型的评估结果显示,在与其他竞争模型进行比较时,它的平均胜率为53-87%,远高于其他模型。此外,在人工评估中,"牧羊人" 模型的表现也优于其他模型,与 ChatGPT 相当。

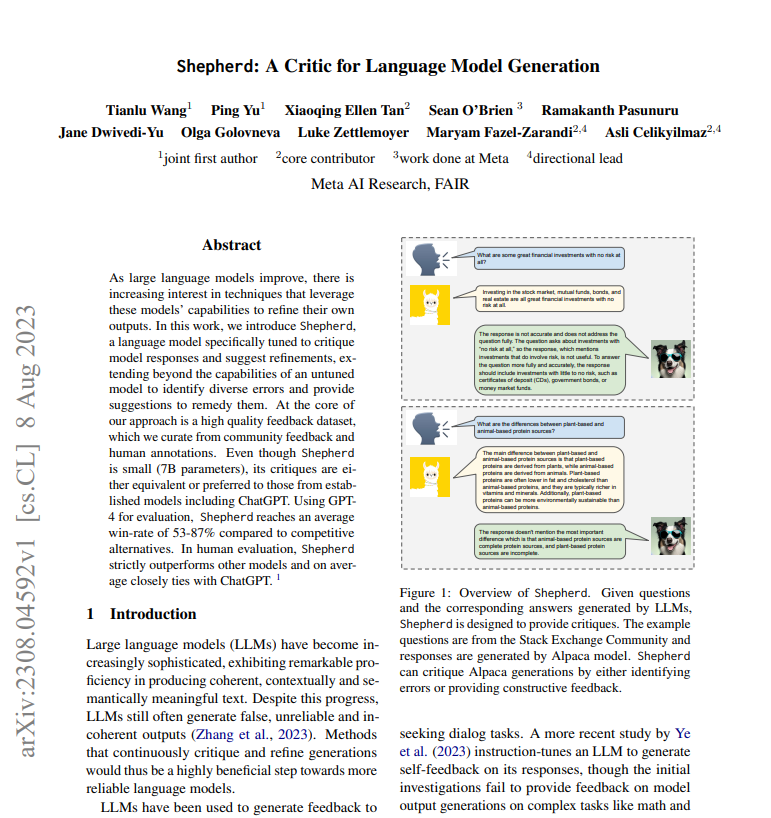

该模型的特点之一是能够生成自然语言的反馈,包括总体判断、一般建议以及领域知识等。它可以识别文本中的问题,如事实性、逻辑错误、连贯性和一致性,并提出改进建议。

论文地址:https://arxiv.org/pdf/2308.04592.pdf

为了微调和评估 "牧羊人" 模型,研究人员创建了一个高质量的反馈数据集,包括社区反馈和人工标注的反馈。通过使用 GPT-4作为评估工具,并选择了6个涵盖广泛主题和推理技能的数据集进行评估。

研究人员发现,"牧羊人" 模型在批判模型生成方面的能力优于其他模型,尤其是在提供正确判断的反馈方面。同时,社区反馈和人工标注的反馈数据对模型的性能有不同的影响,社区反馈更多样化但非正式,而人工标注的数据信息量更大。

总的来说,"牧羊人" 模型展示出了令人印象深刻的结果,在多个下游任务中表现优于其他模型。这一研究对于改进语言模型生成的可靠性非常有益。

语言模型的特点包括:

能够生成连贯、有语境和语义的文本。

能够识别问题,并提供改进建议。

可以涉及领域知识,给出相关的建议。

可以通过社区反馈和人工标注的数据进行微调和评估。

在批判模型生成方面表现优于其他模型。

在多个下游任务中的表现优于其他模型。

对不同类型的任务都能提供反馈。

(举报)